可微分ニューラルコンピュータとは何か?(3)実験の課題

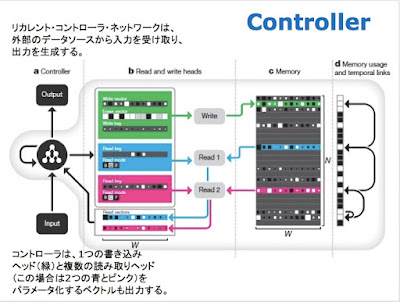

システム概論(続き)

総合的な質問に答える実験

我々の最初の実験では、質問応答を実行するDNCの能力を調査した。 DNCと他のニューラルネットワークアーキテクチャを比較するために、bAbIデータセットを検討した。これには、テキスト推論の側面を真似るように設計された20種類の総合的な質問が含まれている。

データセットは、短い「ストーリー」スニペットとそれに続くストーリーから推測できる答えの質問から構成される。例えば、「ジョンはグランドにいます。ジョンはフットボールをピックアップしました」というストーリーに続いて「フットボールはどこにありますか?」という質問に、グラウンド」と答えには、 システムは2つの裏付けの事実を組み合わせる必要がある。「羊はオオカミを恐れています。」「ガートルードは羊です。」「ネズミはネコを恐れています。」「ガートルードは何を恐れているのですか?」(答え、「オオカミ」)では、基本的な演繹能力(および引っ掛けへの耐性)をテストする。

我々は、1つのDNCを、それぞれにつき10,000のインスタンスを持つ20種類の質問タイプを、すべて一緒に訓練を行い、2種類の質問に対して、タスク失敗(> 5%エラーと定義)で3.8%の平均テストエラー率を達成できることを発見した。 7.5%の平均誤差と6回の失敗したタスクが、過去の最高の学習結果であった。

我々はまた、DNCがLSTM(現在のところ、ほとんどのシーケンス処理タスクのベンチマークとなっているニューラルネットワーク)とニューラルチューリングマシンの両方よりも優れた性能を発揮することも発見した。

グラフ実験

このような文章は、グラフの形式で簡単に表示することができる。たとえば、”John is the playground”は、2つの名前付きノード、’Playground’と ‘John’、名前付きエッジ ‘Contains’によって接続されている。この意味で、多くのbAbIタスクにおける命題で表現される知識は、基礎となるグラフ構造上の制約のセットと同等である。

実際、機械学習が直面する多くの重要なタスクには、解析木、ソーシャルネットワーク、知識グラフ、分子構造などのグラフデータが関係している。したがって、次にランダムに生成されたグラフについて一連の総合的な推論実験を行う。

bAbIとは異なり、グラフのエッジは明示的に提示され、各入力ベクトルは2つのノードラベルとエッジラベルで構成されるトリプルを指定する。ランダムなラベルと接続性をもつトレーニンググラフを作成し、「横断」「最短経路」「推論」の3種類のクエリーを定義した(図2)。

図2

徐々に複雑化していくグラフやクエリを使用したカリキュラムを学習した後、現実のデータを一般化するテストとして、ロンドン地下鉄のシンボリックマップと架空の家系図の2つのグラフをテストした(再トレーニングなし)。

トラバーサル・タスク(図2b)では、ネットワークは、開始ノードを離れた後、生成されたエッジの経路に従って、ランダムウォークで到着したノードを報告するように指示された。

最短経路タスク(図2b)では、ランダムに開始ノードと終了ノードがクエリとして与えられ、ネットワークはそれらの間の最小長のパスに対応するトリプルのシーケンスを返すように求められた。長さが最大5のパスを考えたため、これはbAbIデータセットのパス発見タスクの最大バージョンの2倍となる。

推論タスク(図2c)では、最大5つの接続エッジラベルのシーケンスの略称となる400の「リレーション」ラベルを事前定義した。クエリーは、開始ノードと関係ラベルを指定する不完全なトリプルで構成され、必要な回答は、リレーションシークエンスに従った後の最終ノード。関係シーケンスは決してネットワークに提示されなかったので、クエリとターゲットから推論する必要があった。

ベンチマークとして、DNCとLSTMを再度比較した。この場合、広範なハイパーパラメータ検索で見つかった最高のLSTMネットワークでも、最も簡単なタスク(トラバーサル)のトレーニングカリキュラムの最初のレベルを達成できず、ほぼ200万回のトレーニングの後に平均37%の精度しか達成できなかった。DNCは、約100万回の訓練例の後、同じカリキュラムの最終レッスンで平均98.8%の精度に達した。

図3

図3は、DNCのメモリ割り当て、コンテンツルックアップ、および時間的リンケージを使用してロンドン地下鉄マップを格納し、トラバースする様子を示しています。最短経路で訓練されたDNCの視覚化は、接続経路が見つかるまで、開始ノードおよび終了ノードから放射状にリンクを片っ端から探索することを示唆している。

ブロック・パズル実験

次に、論理的な計画タスクのためにDNCのメモリを活用する能力を調査しようと考えた。これを行うために、我々は、WinogradのSHRDLUに触発されたブロックパズルゲームを作成した。

これは、移動可能なオブジェクトとユーザーの指示を実行するルールベースのエージェントを備えた環境の古典的な人工知能のデモンストレーションである。先の実験が、教師付き学習でネットワークを訓練したのに対し、この実験では目標を記述する一連の命令を、目標を満たしているかどうかを評価する報酬関数と結びつける強化学習の形式をとった。そのセットアップは、シンボリックタスクcueを用いた動物訓練プロトコールに似ている。

Mini-SHRDLUという名付けた我々のの環境には、グリッドボード上に一連の番号付きブロックが含まれている。与えられたボードのビューを入力とみなすエージェントは、トップブロックを列から移動して別の列のスタックの上に置くことができる。

図4

すべてのエピソードで、スタートボードの構成といくつかの可能な目標を作った。 1文字ラベルで識別された各目標は、時間ステップごとに1つの制約が送信される、隣接ブロックペアに関するいくつかの個別の複数の制約から構成されている(目標 ‘T’は「ブロック6はブロック2の下; ブロック4はブロック1の左; ...」(図4b、c)。すべてのゴールが提示された後、1つのゴールラベルがランダムに選択され、エージェントはそのゴールを満たすためにキューに入れられる。

DNCは、ゴールをロケーションに繰り返し書き込むことによって命令を格納するためにそのメモリを使用した(図4a)。その後、選択されたゴールを実行することができた(図4c)。

我々は、ゴールが書かれた時点で、実行前の多くのステップが必要であることを確認した。最初のアクションはメモリからデコードすることができた(図4d)。これは、DNCが、実行する前に、その決定をメモリに書き込んでいることを示している。

このように、明らかに、DNCは計画を立てることを学んでいる。グラフタスクの場合と同様に、学習はボード上のブロック数とゴールの制約を徐々に増加させ、解決策を見つけるために必要な目標数と最小アクション数を増加するカリキュラムに従った。ここでも、DNCはLSTMよりも大幅に優れていた(図5および拡張データ図3参照)。

図5

拡張データ図3

議論

まとめると、bAbIとグラフのタスクは、リンクが暗黙的であるか明示的であるかにかかわらず、DNCがグラフ構造のデータを処理して推論できることを示している。さらに、データソースの構造がコントローラによって学習されたメモリアクセス手順に直接反映されていることがわかった。 Mini-SHRDLUの問題は、DNCがシンボリックな目標を追求することを、強化学習で学ぶ時も、メモリーの体系的な使用が現れることを示している。

これらのタスクをつなぐテーマは、データシーケンスに埋め込まれた複雑な準規則的な構造を表現し、推論することを学ぶ必要があるということである。各問題では、グラフを表現するための規則などのドメインの規則性は、示されたすべてのシーケンスにわたって不変である。一方で、任意の所与の配列について、DNCは、メモリ内のエピソード変数として新しい可変性を検出し把握しなければならない。

大規模な構造と微視的な変動性のこの混合物は、認知エージェントが直面している多くの問題に一般的なものだ。たとえば、ビジュアル・シーン、ストーリー、アクション・プランでは、幅広い規則性が具体例のどんな新しい変異をも結びつける。部屋は統計的に言えば椅子を備えているのだが、部屋の中の特定の椅子の形や場所は変わりる。これらの変数値はDNCの外部メモリに書き込むことができ、コントローラネットワークはグローバルな規則性の学習に自由に集中することができる。

我々の実験は、比較的小規模な総合的タスクに焦点を当てた。これらのタスクは、生成および解釈が容易であるという利点がある。このような問題のためには、最大512個のメモリマトリクスで十分であった。

実世界のデータに取り組むためには、数千または数百万のロケーションにスケールアップする必要がある。その時点で、メモリはコントローラの重みに含まれる情報より多くの情報を格納できる。そのようなシステムは、ネットワークパラメータを適合させなくても、大規模で自然なデータソースにさらされることを通じて知識を絶えず獲得することができなければならない。我々は、ワンショット学習、シーン理解、言語処理、認知マッピングのための表現用エンジンとして機能するDNCをさらに開発し、単一の汎用モデル内で世界の可変構造とスケールを直感的に理解することを目指している。

コメント

コメントを投稿